Inteligența artificială (AI) a devenit o parte esențială a vieții noastre. De la asistenți virtuali la sisteme de recomandare, AI este peste tot. Dar, cu puterea vine și responsabilitatea. Pentru a proteja drepturile cetățenilor și a asigura utilizarea etică a AI, Uniunea Europeană a creat Actul AI. Iată ce trebuie să știi.

Ce Riscuri Există?

Securitatea și Confidențialitatea Datelor

Sistemele AI necesită cantități mari de date pentru a funcționa eficient, iar colectarea și utilizarea acestor date ridică probleme serioase de confidențialitate și securitate. Fără reglementări adecvate, există riscul ca datele personale să fie colectate, stocate și utilizate fără consimțământul utilizatorilor, ceea ce poate duce la breșe de securitate și încălcări ale confidențialității. În plus, AI poate monitoriza și analiza comportamentul utilizatorilor fără consimțământul lor, ridicând probleme serioase de confidențialitate.

Discriminare și Bias Algoritmic

Fără reglementări stricte, AI-ul poate perpetua și amplifica prejudecățile existente în datele pe care a fost antrenat. Algoritmii pot discrimina pe baza rasei, genului, vârstei sau altor caracteristici protejate. De exemplu, un sistem AI de recrutare poate favoriza în mod incorect anumite grupuri de candidați dacă datele de antrenament reflectă prejudecăți istorice. Acest lucru duce la discriminare sistematică și la inechități sociale. De asemenea, fără măsuri de transparență, utilizatorii nu vor putea înțelege sau contesta deciziile luate de AI.

Lipsa de Explicații

Fără reglementări, utilizatorii și autoritățile nu vor înțelege cum se iau deciziile și nu vor putea contesta sau corecta erorile. Aceasta poate fi problematic în situațiile în care este necesară transparența, cum ar fi în deciziile financiare sau juridice. De exemplu, un algoritm de diagnostic medical ar putea da un diagnostic incorect, punând în pericol viața pacienților, iar fără mecanisme de control și transparență, nu există modalități de a corecta aceste erori.

Supravegherea și Controlul Social

Sistemele AI pot fi folosite pentru a monitoriza și controla populația, ceea ce poate duce la societăți mai puțin libere și mai represive. De exemplu, AI poate fi utilizată pentru a urmări comportamentele online și offline ale oamenilor, afectând drepturile lor la confidențialitate și libertate. Acest lucru poate crea un climat de frică și autocenzură, limitând capacitatea oamenilor de a se exprima liber și de a se angaja în activități legitime.

Riscuri pentru Piața Muncii și Economie

Automatizarea bazată pe AI poate duce la pierderea locurilor de muncă, în special în industriile care depind de sarcini repetitive. Fără politici de protecție a muncii și programe de recalificare, mulți muncitori pot fi lăsați fără mijloace de subzistență. De asemenea, AI poate crea o dependență excesivă de tehnologie, ceea ce poate duce la pierderea abilităților și cunoștințelor umane. De exemplu, dacă oamenii se bazează prea mult pe AI pentru navigare, ar putea pierde abilitățile de orientare și navigare tradiționale. Aceste schimbări pot avea efecte economice și sociale profunde, inclusiv inegalitatea și destabilizarea pieței muncii.

Ce este Actul AI?

Actul AI al Uniunii Europene este o lege care stabilește reguli pentru dezvoltarea și utilizarea inteligenței artificiale (AI) în Europa. Scopul principal este să se asigure că AI este folosită în mod sigur, corect și etic, protejând drepturile și siguranța oamenilor.

Obiectivele

Drepturile Fundamentale

Actul AI protejează drepturile fundamentale ale cetățenilor, cum ar fi dreptul la viață privată și la nediscriminare. De exemplu, AI nu trebuie să facă lucruri care ar putea afecta negativ oamenii, cum ar fi discriminarea pe bază de rasă, gen sau alte caracteristici protejate. Algoritmii AI trebuie să fie proiectați și testați pentru a evita prejudecățile existente în datele de antrenament. Astfel, dezvoltatorii de AI sunt obligați să implementeze măsuri care să asigure echitatea și nediscriminarea în utilizarea tehnologiei.

Încrederea în Tehnologie

Pentru ca AI să fie adoptată pe scară largă, cetățenii și companiile trebuie să aibă încredere în această tehnologie. Actul AI creează un cadru de reglementare clar și transparent. Reglementările impun ca sistemele AI să fie transparente în ceea ce privește modul lor de funcționare. De exemplu, utilizatorii trebuie să fie informați dacă interacționează cu un chatbot sau dacă sunt subiectul unei analize bazate pe AI, ceea ce contribuie la prevenirea confuziei și crește încrederea în aceste sisteme.

Siguranța și Securitatea

Actul AI impune standarde stricte pentru sistemele AI, mai ales pentru cele care pot avea un impact mare asupra vieții oamenilor. Aceste standarde includ cerințe de siguranță, precizie și robustețe, menite să prevină accidentele și utilizarea greșită a AI. De exemplu, un sistem AI de diagnostic medical trebuie să fie foarte precis pentru a evita diagnosticările greșite care ar putea pune în pericol viețile pacienților. De asemenea, AI trebuie să fie securizată împotriva atacurilor cibernetice pentru a proteja datele și a preveni utilizările abuzive.

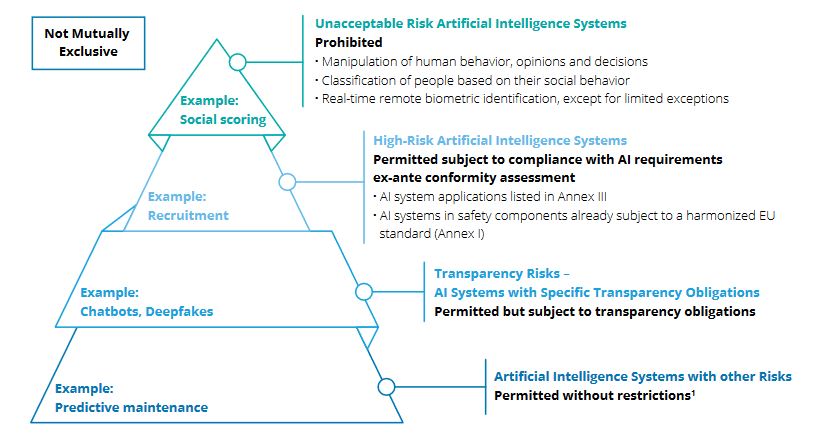

Clasificarea Riscurilor

Actul AI al Uniunii Europene clasifică sistemele de inteligență artificială în funcție de riscurile pe care le prezintă pentru drepturile fundamentale, siguranța și bunăstarea cetățenilor. Acest lucru este esențial pentru a determina nivelul de reglementare și supraveghere necesar pentru fiecare tip de sistem AI. Iată cum se clasifică riscurile în Actul AI:

Risc Inacceptabil: Aceste sisteme sunt interzise. Exemple:

- Scor social: Imaginați-vă un sistem care acordă puncte fiecărui cetățean pe baza comportamentului său social. Oamenii cu punctaje scăzute ar putea fi discriminați.

- Tehnici manipulative: De exemplu, o aplicație care folosește AI pentru a manipula alegerile de cumpărare ale consumatorilor fără ca aceștia să fie conștienți de acest lucru.

Risc Ridicat: Aceste sisteme sunt reglementate strict. Exemple:

- Recrutare: Un software AI folosit pentru a analiza CV-urile și a selecta candidați pentru interviuri. Dacă nu este reglementat, ar putea discrimina anumite grupuri.

- Sănătate: Un AI care ajută la diagnosticarea bolilor. Este esențial ca acesta să fie precis și sigur pentru a evita diagnosticările greșite.

Risc Limitat: Aceste sisteme au obligații de transparență mai ușoare. Utilizatorii trebuie să știe că interacționează cu AI. Exemple:

- Chatbots: Asistenții virtuali folosiți pe site-urile de servicii clienți. Utilizatorii trebuie să știe că vorbesc cu un bot, nu cu o persoană reală.

- Deepfakes: Videoclipuri generate de AI care par reale. Utilizatorii trebuie să fie informați că aceste imagini sunt false.

Risc Minim: Aceste sisteme nu sunt reglementate. Exemple:

- Jocuri video: AI folosită pentru a crea personaje inteligente în jocuri.

- Filtre de spam: AI folosită pentru a identifica și bloca emailurile nedorite.

Obligațiile Furnizorilor de AI cu Risc Ridicat

Furnizorii trebuie să:

- Gestioneze riscurile: Trebuie să aibă un sistem pentru a identifica și a gestiona riscurile pe tot parcursul vieții AI.

- Asigure calitatea datelor: Datele folosite pentru antrenare și testare trebuie să fie corecte și complete.

- Creeze documentația tehnică: Aceasta trebuie să demonstreze conformitatea cu reglementările.

- Permită supravegherea umană: AI trebuie să fie proiectată astfel încât oamenii să poată interveni dacă este necesar.

- Asigure securitatea cibernetică: AI trebuie să fie protejată împotriva atacurilor cibernetice.

Sisteme AI Interzise

Actul AI interzice anumite utilizări ale AI. Exemple:

- Tehnici manipulative: De exemplu, o aplicație care folosește AI pentru a influența comportamentul de vot al oamenilor fără ca aceștia să știe.

- Scorul social: Evaluarea oamenilor pe baza comportamentului lor online și folosirea acestor scoruri pentru a decide cine primește credite sau locuri de muncă.

- Recunoașterea biometrică în timp real: Utilizarea AI pentru a identifica oameni în locuri publice, cu excepții stricte (de exemplu, căutarea persoanelor dispărute).

AI de Uz General

AI de uz general se referă la sisteme de inteligență artificială care sunt capabile să îndeplinească o varietate largă de sarcini diferite, nu doar sarcini specifice pentru care au fost inițial antrenate. Aceste sisteme sunt caracterizate de o flexibilitate semnificativă, ceea ce le permite să fie aplicate în multiple domenii și contexte. Exemple:

- Generare text: AI care scrie articole de știri sau postări pe blog.

- Generare imagini: AI care creează imagini realiste.

Furnizorii de AI de uz general trebuie să:

- Elaboreze documentația tehnică: Trebuie să includă detalii despre procesul de antrenare și testare.

- Publice informații despre datele folosite: Utilizatorii trebuie să știe ce date au fost folosite pentru antrenarea AI.

- Respecte drepturile de autor: Trebuie să se asigure că nu încalcă drepturile de autor atunci când folosesc date pentru antrenare.

Cum vor fi Aplicate Reglementările

Pentru a asigura respectarea Actului AI, Uniunea Europeană va înființa un Birou AI. Acesta va funcționa sub auspiciile Comisiei Europene și va monitoriza implementarea și conformitatea furnizorilor de AI. Rolurile principale ale Biroului AI includ:

- Monitorizarea conformității: Biroul va verifica dacă furnizorii de AI respectă reglementările Actului AI. Aceasta include revizuirea documentației tehnice și a proceselor de antrenare a datelor.

- Evaluarea riscurilor sistemice: Biroul va efectua evaluări pentru a identifica și atenua riscurile asociate cu sistemele AI, în special cele care pot avea un impact sistemic asupra societății.

- Asistență pentru autoritățile naționale: Biroul AI va colabora cu autoritățile de supraveghere din statele membre pentru a asigura o aplicare uniformă a reglementărilor în toată Uniunea Europeană.

- Gestionarea plângerilor: Utilizatorii și companiile pot depune plângeri la Biroul AI dacă suspectează încălcări ale Actului AI. Biroul va investiga aceste plângeri și va lua măsuri corespunzătoare.

Fiecare stat membru al UE va trebui să desemneze o autoritate națională de supraveghere a pieței. Această autoritate va colabora cu Biroul AI și va asigura conformitatea la nivel național. De asemenea, autoritățile naționale vor avea puterea de a investiga și de a lua măsuri împotriva furnizorilor de AI care nu respectă reglementările.

Penalități

Actul AI prevede penalități semnificative pentru nerespectarea reglementărilor. Aceste penalități sunt concepute pentru a asigura conformitatea și pentru a descuraja practicile necorespunzătoare în utilizarea inteligenței artificiale. Iată principalele aspecte legate de penalitățile prevăzute în Actul AI:

Nivelurile de Penalități

- Până la 35 de milioane de euro sau 7% din cifra de afaceri globală anuală pentru încălcările grave care implică sistemele AI cu risc ridicat. Aceste încălcări pot include nerespectarea cerințelor esențiale de siguranță și performanță, utilizarea de sisteme AI interzise sau lipsa supravegherii umane adecvate.

- Până la 15 milioane de euro sau 3% din cifra de afaceri globală anuală pentru încălcările mai puțin grave, dar semnificative, ale cerințelor privind sistemele AI cu risc ridicat. Acestea pot include lipsa de transparență sau insuficientă documentație tehnică.

- Până la 7,5 milioane de euro sau 1,5% din cifra de afaceri globală anuală pentru furnizarea de informații incorecte, incomplete sau înșelătoare către autorități. Aceasta se aplică în cazul în care informațiile furnizate în cadrul evaluărilor de conformitate sau al raportărilor nu sunt corecte sau complete.

Cine Este Afectat?

Furnizorii de AI:

- Aceștia sunt principalii responsabili pentru conformitatea sistemelor AI cu risc ridicat. Ei trebuie să se asigure că toate cerințele Actului AI sunt respectate pe parcursul întregului ciclu de viață al produsului.

Implementatorii de AI:

- Implementatorii, care folosesc sisteme AI în scopuri profesionale, au și ei anumite obligații, deși mai puține decât furnizorii. Ei trebuie să se asigure că utilizează sistemele AI în mod responsabil și conform cu reglementările.

Utilizatorii de AI:

- Utilizatorii finali, în special cei care folosesc sisteme AI cu risc ridicat, trebuie să fie conștienți de riscurile și obligațiile asociate. De exemplu, dacă o companie folosește un sistem AI pentru recrutare, trebuie să se asigure că acesta nu discriminează candidații.

Măsuri pentru Conformitate

Pentru a evita penalitățile, companiile trebuie să:

- Dezvolte și implementeze sisteme de management al riscurilor: Acestea trebuie să acopere toate aspectele legate de utilizarea AI, de la antrenarea modelului până la monitorizarea și întreținerea acestuia.

- Asigure transparența și documentația completă: Toate datele folosite pentru antrenarea și testarea AI trebuie să fie documentate și disponibile pentru autorități.

- Permită supravegherea umană: Sistemele AI trebuie să fie proiectate astfel încât oamenii să poată interveni în cazul în care apare o problemă.

- Monitorizeze și raporteze incidentele: Orice incident semnificativ trebuie raportat rapid autorităților competente pentru a se lua măsuri corective.

Exemple Practice

- Un furnizor de AI care nu respectă cerințele de transparență și nu informează utilizatorii că interacționează cu un chatbot ar putea fi amendat cu până la 15 milioane de euro sau 3% din cifra de afaceri globală.

- O companie care folosește un sistem AI pentru evaluarea performanței angajaților fără a asigura că sistemul nu discriminează pe bază de gen sau rasă ar putea fi supusă unei amenzi de până la 35 de milioane de euro sau 7% din cifra de afaceri globală.

Când va fi Implementat

Actul AI va fi implementat treptat pentru a permite companiilor să se adapteze la noile reglementări. Termenele sunt următoarele:

- 6 luni pentru sistemele AI interzise: Aceste sisteme trebuie retrase de pe piață imediat după această perioadă.

- 12 luni pentru AI de uz general: Furnizorii de AI de uz general trebuie să se conformeze noilor reglementări într-un an.

- 24 luni pentru sistemele AI cu risc ridicat din Anexa III: Aceste sisteme vor avea doi ani pentru a implementa cerințele necesare.

- 36 luni pentru sistemele AI cu risc ridicat din Anexa I: Aceste sisteme vor avea trei ani pentru a se conforma noilor reguli.

Impactul Asupra Utilizatorilor

Actul AI al UE protejează utilizatorii în mai multe moduri:

- Transparență: Utilizatorii vor ști când interacționează cu un sistem AI. De exemplu, dacă vorbesc cu un chatbot pe un site de servicii clienți, vor fi informați că vorbesc cu un bot și nu cu o persoană reală. Aceasta ajută la prevenirea confuziei și la creșterea încrederii în tehnologie.

- Securitate și Confidențialitate: Actul AI impune măsuri stricte pentru a proteja datele personale ale utilizatorilor. De exemplu, AI folosită în diagnosticarea medicală va fi securizată pentru a preveni accesul neautorizat la datele pacienților. Aceasta ajută la protejarea confidențialității și la prevenirea abuzurilor.

- Evitarea Discriminării: Reglementările asigură că AI nu discriminează pe baza rasei, genului, religiei sau altor caracteristici protejate. De exemplu, un sistem AI folosit pentru recrutare va fi testat pentru a evita discriminarea împotriva anumitor grupuri. Acest lucru ajută la promovarea echității și la asigurarea unor oportunități egale pentru toți.

- Supravegherea Umană: Furnizorii de AI trebuie să proiecteze sisteme care să permită intervenția umană. De exemplu, în cazul unui diagnostic medical AI, medicii trebuie să poată revizui și să confirme sau să infirme rezultatele generate de AI.

- Acces la Recurs: Utilizatorii care sunt afectați de deciziile luate de AI au dreptul de a contesta aceste decizii. De exemplu, dacă un sistem AI refuză acordarea unui credit, utilizatorul va solicita o revizuire umană a deciziei. Aceasta ajută la protejarea drepturilor și la asigurarea unui tratament echitabil.

Actul AI al UE este esențial pentru a asigura că AI este utilizată etic și sigur. Riscurile clasificate și reglementările clare vor proteja drepturile cetățenilor și vor promova încrederea în tehnologie. Actul AI creează un mediu de încredere în care inovația va prospera, iar întreaga societate va avea de câștigat. Tu ce părere ai?